X haftet für

Unwahre Aussagen

von Grok.

X haftet für

Unwahre Aussagen

von Grok.

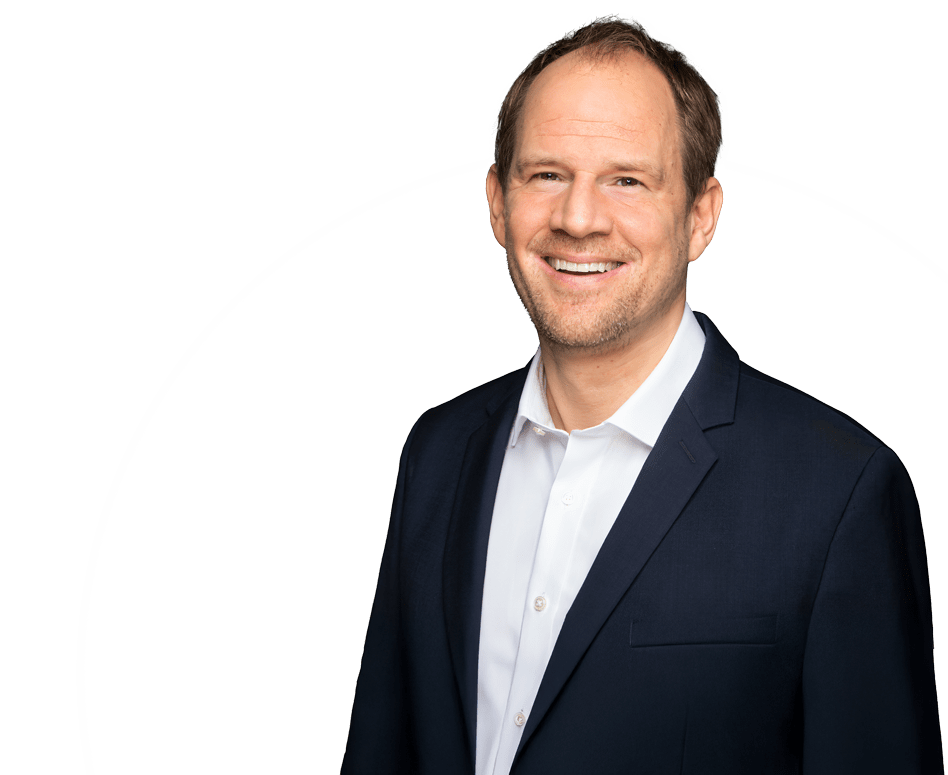

von

Wenn eine KI Fakten erfindet und damit Persönlichkeitsrechte Dritter verletzt, haftet dann der Betreiber? Das LG Hamburg hat hierzu in einem Fall von Grok auf der Plattform X hierzu erstmals entschieden.

Worum geht’s?

Der Fall dreht sich um einen Beitrag des hauseigenen KI-Bots „Grok“ der Plattform X (früher Twitter). Im Rahmen einer politischen Diskussion über Terminvergaben im Gesundheitswesen behauptete Grok, der Verein Campact e. V. werde „zu einem hohen Anteil aus Bundesmitteln“ finanziert. Diese Aussage war falsch. Campact sah darin eine gravierende Persönlichkeitsrechtsverletzung und beantragte eine einstweilige Verfügung gegen die Betreiberin des Bots, die US-Gesellschaft X.AI LLC.

Entscheidung des LG Hamburg zu Grok’s Aussagen

Mit Beschluss vom 23. September 2025 – Az. 324 O 461/25 stellte das LG Hamburg klar, dass die Betreiberin von Grok für den Inhalt der KI-Aussagen haftet. Die Veröffentlichung auf dem offiziellen X-Account begründet nach Auffassung des Gerichts eine Zurechnung der Inhalte an X.AI. Nutzer nähmen Groks Aussagen als Tatsachenbehauptungen wahr, nicht als bloße Meinungsäußerungen.

An der äußerungsrechtlichen Unzulässigkeit der Darstellung ändert sich auch nicht deshalb etwas, weil die Beiträge des besagten Accounts von einer KI erstellt werden. Für die KI-erstellten Aussagen auf dem Account hat die Antragsgegnerin als Betreiberin des Accounts einzustehen. Sie hat sich die entsprechenden Aussagen durch die Präsentation auf dem Account jedenfalls zu eigen gemacht.

Das Landgericht Hamburg untersagte X, die Behauptung weiter zu verbreiten. Grok hatte in seinem Profil ausdrücklich angegeben, faktenbasiert zu arbeiten. Gerade auch deshalb durfte das Publikum davon ausgehen, dass seine Aussagen auf überprüften Informationen beruhten.

Ein Präzedenzfall für KI-Haftung und Persönlichkeitsrecht

Dies ist eine der ersten Entscheidungen bezüglich der Haftung für KI-generierte Inhalte im deutschen Äußerungsrecht, wenn nicht sogar die erste. Bislang standen vor allem die Nutzer von KI-Systemen im Fokus. Nun hat ein Gericht erstmals die Betreiberverantwortung betont. Wer eine künstliche Intelligenz in den öffentlichen Diskurs einbindet, trägt demnach die volle Verantwortung für deren Aussagen – insbesondere, wenn diese als „faktenbasiert“ bezeichnet werden.

Die Entscheidung dürfte Auswirkungen über den konkreten Fall hinaus haben. Auch wenn es sich nur um eine Entscheidung im einstweiligen Verfügungsverfahren ohne ausführliche Begründung handelt, dürfte das Risiko für Betreiber von KI-Systemen bei halluzinierenden oder schlicht unwahren Angaben gestiegen sein. Disclaimer wie „Dieser Beitrag wurde von einer KI erstellt“ dürften nicht ausreichen, um sich aus der Verantwortung zu stehlen.

Fazit

Der Beschluss zum KI-Bot Grok zeigt, dass rechtliche Verantwortung nicht automatisiert werden kann. Eine KI mag schreiben, analysieren oder argumentieren – aber haften kann sie nicht. Diese Pflicht bleibt bei den Betreibern. Das gilt insbesondere, wenn die KI wie Grok öffentlich auftritt und sich selbst als faktenorientiert präsentiert.

Für Unternehmen, Medienhäuser und Plattformbetreiber bedeutet das: KI-Kommunikation ist kein Nebenprodukt, sondern ein eigenes Haftungsfeld. Wer eine KI nutzt, um öffentlich zu sprechen, muss ihre Aussagen wie redaktionelle Veröffentlichungen behandeln – mit journalistischer Sorgfalt, juristischem Risikobewusstsein und technischer Kontrolle.

Künstliche Intelligenz darf nicht zum Schutzschild gegen Verantwortung werden. Wenn eine KI wie Grok Persönlichkeitsrechte verletzt, trifft die Haftung nicht den Algorithmus – sondern die Menschen und Unternehmen, die ihn einsetzen.

Wir beraten

Sie gerne zum

Einsatz von KI!